Obiettivi | Certificazione | Contenuti | Tipologia | Prerequisiti | Durata e Frequenza | Docenti | Modalità di Iscrizione | Calendario

Il Corso Data Integration with Cloud Data Fusion è un programma di formazione di livello intermedio della durata di due giorni, pensato per introdurre i partecipanti alle capacità di integrazione dei dati di Google Cloud utilizzando Cloud Data Fusion. Il corso affronta le sfide dell’integrazione dei dati e la necessità di una piattaforma di integrazione dei dati, illustrando come Cloud Data Fusion possa aiutare a integrare efficacemente dati provenienti da una varietà di fonti e formati. I partecipanti impareranno a progettare ed eseguire pipeline di elaborazione dei dati in batch e in tempo reale, a lavorare con Wrangler per costruire trasformazioni di dati, a utilizzare connettori per integrare dati da varie fonti e formati, e a configurare ambienti di esecuzione. Il corso è rivolto principalmente a Data Engineers e Data Analysts che hanno completato il corso “Big Data and Machine Learning Fundamentals”. Il corso contribuisce alla preparazione dell’esame di Certificazione Google Professional Data Engineer.

Contattaci ora per ricevere tutti i dettagli e per richiedere, senza alcun impegno, di parlare direttamente con uno dei nostri Docenti (Clicca qui)

oppure chiamaci subito al nostro Numero Verde (800-177596)

Obiettivi del corso

Di seguito una sintesi degli obiettivi principali del Corso Data Integration with Cloud Data Fusion:

- Acquisire familiarità con le funzionalità di Cloud Data Fusion.

- Progettare ed eseguire pipeline di elaborazione dati.

- Utilizzare Wrangler per le trasformazioni dei dati.

- Impiegare connettori per l’integrazione di dati da diverse fonti.

- Configurare ambienti di esecuzione per pipeline di dati.

Certificazione del corso

Esame Google Cloud Certified Professional Data Engineer; L’esame misura la capacità di progettare, costruire e gestire soluzioni di elaborazione dati sicure e scalabili su Google Cloud Platform. Testa conoscenze specialistiche in servizi come BigQuery per l’analisi di grandi dataset, Cloud Dataflow per la costruzione di pipeline di dati, e Cloud Dataproc per l’elaborazione di workload Hadoop/Spark. L’esame richiede anche competenze nella gestione di modelli di machine learning e nella scelta delle migliori strategie di storage e gestione dei dati. Candidati devono dimostrare l’uso efficace di Python e SQL per manipolare e analizzare i dati all’interno dell’ecosistema GCP.

Contenuti del corso

Module 01: Introduction to data integration and Cloud Data Fusion

- Data integration: what, why, challenges

- Data integration tools used in industry

- User personas

- Introduction to Cloud Data Fusion

- Data integration critical capabilities

- Cloud Data Fusion UI components

- Understand the need for data integration

- List the situations/cases where data integration can help businesses

- List the available data integration platforms and tools

- Identify the challenges with data integration

- Understand the use of Cloud Data Fusion as a data integration platform

- Create a Cloud Data Fusion instance

- Familiarize with core framework and major components in Cloud Data Fusion

Module 02: Building pipelines

- Cloud Data Fusion architecture

- Core concepts

- Data pipelines and directed acyclic graphs (DAG)

- Pipeline Lifecycle

- Designing pipelines in Pipeline Studio

- Understand Cloud Data Fusion architecture

- Define what a data pipeline is

- Understand the DAG representation of a data pipeline

- Learn to use Pipeline Studio and its components

- Design a simple pipeline using Pipeline Studio

- Deploy and execute a pipeline

Module 03: Designing complex pipelines

- Branching, Merging and Joining

- Actions and Notifications

- Error handling and Macros

- Pipeline Configurations, Scheduling, Import and Export

- Perform branching, merging, and join operations

- Execute pipeline with runtime arguments using macros

- Work with error handlers

- Execute pre- and post-pipeline executions with help of actions and notifications

- Schedule pipelines for execution

- Import and export existing pipelines

Module 04: Pipeline execution environment

- Schedules and triggers

- Execution environment: Compute profile and provisioners

- Monitoring pipelines

- Understand the composition of an execution environment

- Configure your pipeline’s execution environment, logging, and metrics. Understand concepts like compute profile and provisioner

Module 05: Building Transformations and Preparing Data with Wrangler

- Wrangler

- Directives

- User-defined directives

- Understand the use of Wrangler and its main components

- Transform data using Wrangler UI

- Transform data using directives/CLI methods

- Create and use user-defined directives

Module 06: Connectors and streaming pipelines

- Understand the data integration architecture

- List various connectors

- Use the Cloud Data Loss Prevention (DLP) API

- Understand the reference architecture of streaming pipelines

- Build and execute a streaming pipeline

- Connectors

- DLP

- Reference architecture for streaming applications

- Building streaming pipelines

Module 07: Metadata and data lineage

- Metadata

- Data lineage

- List types of metadata

- Differentiate between business, technical, and operational metadata

- Understand what data lineage is

Module 08: Course Summary

- Understand the importance of maintaining data lineage

- Differentiate between metadata and data lineage

Tipologia

Corso di Formazione con Docente

Docenti

I docenti sono Istruttori accreditati Google Cloud e certificati in altre tecnologie IT, con anni di esperienza pratica nel settore e nella Formazione.

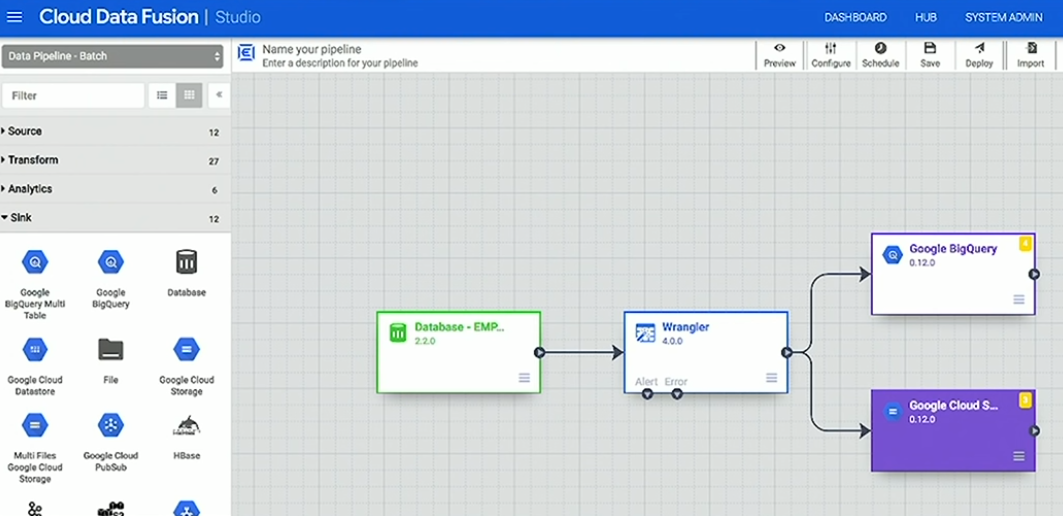

Infrastruttura laboratoriale

Per tutte le tipologie di erogazione, il Corsista può accedere alle attrezzature e ai sistemi presenti nei Nostri laboratori o direttamente presso i data center del Vendor o dei suoi provider autorizzati in modalità remota h24. Ogni partecipante dispone di un accesso per implementare le varie configurazioni avendo così un riscontro pratico e immediato della teoria affrontata. Ecco di seguito alcuni scenari tratti dalle attività laboratoriali:

Dettagli del corso

Prerequisiti

Si consiglia la partecipazione al Corso Google Cloud Big Data and Machine Learning Fundamentals.

Durata del corso

- Durata Intensiva 2gg;

Frequenza

Varie tipologie di Frequenza Estensiva ed Intensiva.

Date del corso

- Corso Data Integration with Cloud Data Fusion (Formula Intensiva) – Su richiesta – 9:00 – 17:00

Modalità di iscrizione

Le iscrizioni sono a numero chiuso per garantire ai tutti i partecipanti un servizio eccellente.

L’iscrizione avviene richiedendo di essere contattati dal seguente Link, o contattando la sede al numero verde 800-177596 o inviando una richiesta all’email [email protected].