Obiettivi | Certificazione | Contenuti | Tipologia | Prerequisiti | Durata e Frequenza | Docenti | Modalità di Iscrizione | Calendario

Il Corso Data Warehousing su AWS (DBDWOA) introduce i partecipanti a concetti, strategie e best practice per la progettazione di una soluzione di data warehousing basata su cloud AWS utilizzando Amazon Redshift, il data warehouse su scala petabyte in AWS. Questo corso insegna come raccogliere, archiviare e preparare i dati per il data warehouse utilizzando servizi AWS come Amazon DynamoDB, Amazon EMR, Amazon Kinesis e Amazon S3. Inoltre, questo corso dimostra come utilizzare Amazon QuickSight per eseguire analisi sui dati. Il corso contribuisce alla preparazione per la Certificazione AWS Certified Data Engineer – Associate.

Contattaci ora per ricevere tutti i dettagli e per richiedere, senza alcun impegno, di parlare direttamente con uno dei nostri Docenti (Clicca qui)

oppure chiamaci subito al nostro Numero Verde (800-177596)

Obiettivi del corso

Di seguito una sintesi degli obiettivi principali del corso Corso Data Warehousing on AWS (DBDWOA):

- Introduzione a concetti, strategie e best practice per progettare una soluzione di data warehousing su AWS utilizzando Amazon Redshift.

- Apprendimento su come raccogliere, archiviare e preparare i dati per il data warehouse con l’uso di servizi AWS come Amazon DynamoDB, Amazon EMR, Amazon Kinesis e Amazon S3.

- Utilizzo di Amazon Redshift, il data warehouse di AWS in grado di gestire dati su scala petabyte.

- Dimostrazione su come utilizzare Amazon QuickSight per eseguire analisi sui dati.

- Fornire competenze su come progettare una soluzione di data warehousing basata su cloud AWS.

Certificazione del corso

Esame AWS Certified Data Engineer – Associate;

L’esame AWS Certified Data Engineer – Associate DEA-C01 valuta la capacità di un candidato di implementare pipeline di dati, monitorare, risolvere problemi e ottimizzare costi e prestazioni in conformità con le best practice. Gli esaminati devono dimostrare competenze nell’ingestione e trasformazione dei dati, orchestrazione delle pipeline di dati e applicazione di concetti di programmazione. Inoltre, devono essere in grado di scegliere il data store ottimale, progettare modelli di dati, catalogare schemi di dati e gestire i cicli di vita dei dati. Altre competenze richieste includono l’operazionalizzazione, manutenzione e monitoraggio delle pipeline di dati, analisi dei dati e garanzia della qualità dei dati. Gli esaminati devono anche implementare meccanismi appropriati di autenticazione, autorizzazione, crittografia dei dati, privacy e governance, oltre ad abilitare il logging. Le conoscenze richieste includono le caratteristiche di throughput e latenza per i servizi AWS che ingeriscono dati, schemi di ingestione dei dati, elaborazione dei dati utilizzando Apache Spark, e architetture event-driven. Gli esaminati devono saper integrare vari servizi AWS per creare pipeline ETL, configurare servizi AWS per pipeline di dati basate su schedulazioni o dipendenze, e ottimizzare i costi durante l’elaborazione dei dati. Inoltre, è necessaria la conoscenza dei concetti di programmazione quali CI/CD, query SQL e infrastruttura come codice (IaC). L’esame richiede anche competenze nell’automazione dell’elaborazione dei dati utilizzando i servizi AWS, visualizzazione dei dati, verifica e pulizia dei dati, e monitoraggio delle pipeline di dati. Infine, gli esaminati devono dimostrare la capacità di applicare meccanismi di autenticazione e autorizzazione, garantire la crittografia e mascheramento dei dati, preparare i log per audit, e implementare strategie di privacy e governance dei dati.

Contenuti del corso

Module 1: Introduction to Data Warehousing

- Relational databases

- Data warehousing concepts

- The intersection of data warehousing and big data

- Overview of data management in AWS

- Hands-on lab 1: Introduction to Amazon Redshift

Module 2: Introduction to Amazon Redshift

- Conceptual overview

- Real-world use cases

- Hands-on lab 2: Launching an Amazon Redshift cluster

Module 3: Launching clusters

- Building the cluster

- Connecting to the cluster

- Controlling access

- Database security

- Load data

- Hands-on lab 3: Optimizing database schemas

Module 4: Designing the database schema

- Schemas and data types

- Columnar compression

- Data distribution styles

- Data sorting methods

Module 5: Identifying data sources

- Data sources overview

- Amazon S3

- Amazon DynamoDB

- Amazon EMR

- Amazon Kinesis Data Firehose

- AWS Lambda Database Loader for Amazon Redshift

- Hands-on lab 4: Loading real-time data into an Amazon Redshift database

Module 6: Loading data

- Preparing Data

- Loading data using COPY

- Maintaining tables

- Concurrent write operations

- Troubleshooting load issues

- Hands-on lab 5: Loading data with the COPY command

Module 7: Writing queries and tuning for performance

- Amazon Redshift SQL

- User-Defined Functions (UDFs)

- Factors that affect query performance

- The EXPLAIN command and query plans

- Workload Management (WLM)

- Hands-on lab 6: Configuring workload management

Module 8: Amazon Redshift Spectrum

- Amazon Redshift Spectrum

- Configuring data for Amazon Redshift Spectrum

- Amazon Redshift Spectrum Queries

- Hands-on lab 7: Using Amazon Redshift Spectrum

Module 9: Maintaining clusters

- Audit logging

- Performance monitoring

- Events and notifications

- Lab 8: Auditing and monitoring clusters

- Resizing clusters

- Backing up and restoring clusters

- Resource tagging and limits and constraints

- Hands-on lab 9: Backing up, restoring and resizing clusters

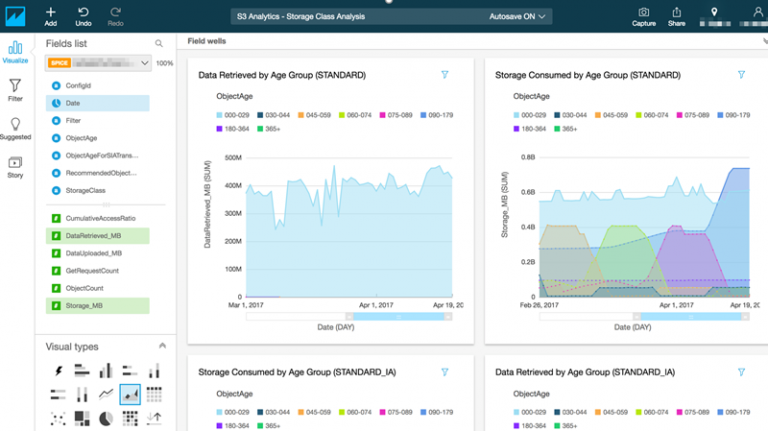

Module 10: Analyzing and visualizing data

- Power of visualizations

- Building dashboards

- Amazon QuickSight editions and features

Tipologia

Corso di Formazione con Docente

Docenti

I docenti sono Istruttori accreditati Amazon AWS e certificati in altre tecnologie IT, con anni di esperienza pratica nel settore e nella Formazione.

Infrastruttura laboratoriale

Per tutte le tipologie di erogazione, il Corsista può accedere alle attrezzature e ai sistemi presenti nei Nostri laboratori o direttamente presso i data center del Vendor o dei suoi provider autorizzati in modalità remota h24. Ogni partecipante dispone di un accesso per implementare le varie configurazioni avendo così un riscontro pratico e immediato della teoria affrontata. Ecco di seguito alcuni scenari tratti dalle attività laboratoriali:

Dettagli del corso

Prerequisiti

Si consiglia la partecipazione al Corso AWS Technical Essentials e al Corso Data Analytics Fundamentals.

Durata del corso

Durata Intensiva 3gg.

Frequenza

Varie tipologie di Frequenza Estensiva ed Intensiva.

Date del corso

- Data Warehousing on AWS (Formula Intensiva) – Su Richiesta – 09:00/17:00

Modalità di iscrizione

Le iscrizioni sono a numero chiuso per garantire ai tutti i partecipanti un servizio eccellente. L’iscrizione avviene richiedendo di essere contattati dal seguente Link, o contattando la sede al numero verde 800-177596 o inviando una richiesta all’email [email protected].